# Exemplo: Atribuição de valores a variáveis

receita_mensal <- 850000 # Receita mensal da empresa

custos_mensais <- 500000 # Custos mensais

# Cálculo do lucro

lucro_mensal <- receita_mensal - custos_mensais

lucro_mensal[1] 350000Um tutorial básico sobre a linguagem R para Ciência de Dados.

Prof. Dr. Washington S. da Silva

7 julho 2024

Este tutorial é destinado aos estudantes do bacharelado em Administração e aos mestrandos do Mestrado Profissional em Administração do IFMG - Campus Formiga.

Também é útil para administradores, economistas, contabilistas, auditores e outros profissionais que desejam utilizar ferramentas modernas para criar relatórios e outros produtos de forma reproduzível e auditável.

O objetivo principal é proporcionar uma compreensão sólida da linguagem R, desde seus fundamentos até aplicações em análise de dados, permitindo que alunos de graduação, mestrandos e demais profissionais e pesquisadores interessados desenvolvam habilidades para criar análises reproduzíveis e auditáveis. Embora o foco inicial seja a Ciência de Dados aplicada à Administração, o conteúdo foi elaborado para ser útil em diversas áreas do conhecimento.

Acesse https://cloud.r-project.org/

Selecione o sistema operacional, clicando em Download R for Windows por exemplo.

Na página seguinte clique em base.

Clique em Download R-4.4.3 for Windows.

Feito o download basta ir clicando em próximo/next até a instalação ser concluída.

Para uma experiência de programação mais produtiva com R, recomenda-se fortemente o uso do RStudio, um IDE (Ambiente de Desenvolvimento Integrado) especialmente projetado para trabalhar com a linguagem R.

O RStudio oferece diversas funcionalidades que facilitam o aprendizado e uso da linguagem, como editor de código com destaque de sintaxe, projetos Rstudio, integração com Git e suporte nativo ao sistema Quarto.

Para instalar e configurar o RStudio, consulte nosso Tutorial sobre RStudio, onde são apresentadas instruções detalhadas para iniciantes.

Embora seja perfeitamente possível utilizar R com outros IDEs, a combinação (R + RStudio) facilita e potencializa significativamente a experiência de aprendizado e desenvolvimento.

R é um ambiente ou sistema para computação estatística e gráfico.

Este sistema é composto por duas partes: a própria linguagem R (que é o que a maioria das pessoas querem dizer quando falam sobre R) e um ambiente de tempo de execução (runtime environment).

R é uma linguagem interpretada, o que significa que os usuários acessam suas funções por meio de um interpretador de linha de comando.

Ao contrário de linguagens como Python e Java, R não é uma linguagem de programação de uso geral.

Em vez disso, R é considerada uma linguagem de domínio específica (DSL), o que significa que suas funções e uso foram projetados para uma área específica de uso ou domínio.

No caso de R, o domínio e a computação estatística. Por extensão, R é comumente usada para todos os tipos de tarefas de ciência de dados.

A linguagem R está equipada com um grande conjunto de funções internas para a manipulação, análise e visualização de dados.

Além das funções internas da linguagem, existem inúmeros pacotes (como os módulos de Python) que estendem as capacidades da linguagem.

A linguagem S

A linguagem S foi desenvolvida em meados da década de 1970 por John Chambers no lendário Bell Labs. O objetivo era oferecer uma abordagem interativa para a computação estatística, que fosse fácil de usar e tornasse as tarefas de análise de dados mais fáceis e rápidas.

Em uma entrevista de 2013, Chambers observou que a equipe do Bell Labs queria que as pessoas começassem em um ambiente interativo, onde não pensassem em si como programadores. Então, à medida que suas necessidades se tornaram mais claras e sua sofisticação aumentasse, eles dseriam capazes de se orientar gradualmente para a programação com a linguagem S.

A filosofia geral de S era muito semelhante à de R: oferecer um ambiente de software que facilitasse a programação computacional e a análise estatística, que qualquer um possa aprender a usar.

Como R, S também pode ser usada para escrever programas mais longos centrados em tarefas estatísticas. Ao contrário de R, no entanto, S e sua iteração posterior, S-Plus, eram produtos licenciados, o que significa que tinham que ser comprados de uma empresa.

Portanto, é importante notar que a linguagem R é um dialeto da linguagem S.

Sintáxe e Semântica

Os linguistas usam os termos sintaxe e semântica para descrever elementos de linguagens naturais, e os cientistas da computação também adotaram esses termos para linguagens de programação.

Na programação de computadores, a sintaxe se refere às regras que ditam a ‘ortografia’ e a ‘gramática’ de uma linguagem, enquanto a semântica se refere a como os dados ou comandos de uma linguagem são apresentados.

A sintaxe de R era muito semelhante à de S em seus primeiros anos. Isso tornou mais fácil para as pessoas que usavam S-Plus mudar para R, o que desempenhou um papel fundamental na eventual popularidade de R na academia.

A semântica de R, no entanto, está mais próxima da linguagem Scheme, uma linguagem de programação funcional.

R é uma linguagem de baixo ou alto nível?

R é considerada uma linguagem de programação de alto nível. Essa classificação é baseada em seu nível de abstração da linguagem de máquina.

Ao contrário das linguagens de baixo nível que exigem conhecimento aprofundado da memória e dos processos do computador, linguagens de alto nível como R são projetadas para serem facilmente compreendidas e escritas por humanos, tornando-as mais acessíveis para estatísticos, analistas de dados e pesquisadores.

1991: Os professores e estatísticos Ross Ihaka e Robert Gentleman começam a trabalhar em um novo dialeto da linguagem S como um projeto de pesquisa para o Departamento de Estatística da Universidade de Auckland na Nova Zelândia.

1993: O primeiro anúncio de R chega ao público através do arquivo de dados StatLib e da lista de discussão s-news.

1995: O estatístico Martin Mächler convence os criadodes de R a lançar a linguagem sob uma licença pública geral GNU, tornando R gratuita e de código aberto. Ihaka e Gentleman lançam seu artigo seminal apresentando R ao mundo.

1997: O R Core Team foi formado, este grupo é o único com acesso ao código-fonte R. No mesmo ano, foi criada a Comprehensive R Archive Network (CRAN). Este repositório de pacotes R ajuda os profissionais em inúmeras tarefas.

2000: R versão 1.0.0 foi lançada ao público.

Março de 2024: Estamos atualmente na versão R 4.3.3

Gratuito e de código aberto: Diferentemente de softwares estatísticos proprietários, R é completamente gratuito e seu código-fonte é aberto, permitindo total transparência e personalização.

Especialmente projetado para análise estatística e ciência de dados: Enquanto outras linguagens podem ser adaptadas para estas tarefas, R foi concebida especificamente para computação estatística e visualização de dados.

Ampla comunidade acadêmica e profissional: R possui uma comunidade ativa de usuários que contribuem constantemente com novos pacotes, métodos e soluções para problemas complexos.

Integração com o sistema Quarto: Perfeita compatibilidade com o sistema de publicação Quarto, permitindo a criação de documentos, apresentações e websites dinâmicos e reproduzíveis.

Ecossistema Tidyverse: O conjunto de pacotes Tidyverse fornece uma gramática consistente para manipulação, visualização e modelagem de dados, especialmente útil para iniciantes.

Excelência em visualização de dados: Pacotes como ggplot2 permitem criar visualizações estatísticas sofisticadas e personalizáveis.

Relevância no mercado: Profissionais com conhecimento em R são valorizados em setores como finanças, consultorias, pesquisa de mercado e análise de negócios.

Reprodutibilidade científica: R facilita a implementação de práticas de ciência reproduzível, essencial para pesquisas acadêmicas e relatórios corporativos auditáveis.

Versatilidade em tipos de análise: Desde estatísticas descritivas simples até modelos complexos de machine learning e econometria aplicada, R oferece ferramentas para diversos níveis de análise.

Documentação extensa: Ampla disponibilidade de documentação, tutoriais, livros e recursos online, facilitando o aprendizado contínuo.

Nas próximas seções do tutorial vamos explorar os conceitos básicos da linguagem R, que servirão como alicerce para os tópicos posteriores. Compreender esses fundamentos é essencial antes de avançarmos para análises mais complexas.

Em R, os termos “variável” e “objeto” são frequentemente usados de forma intercambiável, o que pode causar confusão inicial, especialmente para quem já possui experiência com outras linguagens de programação. Esta seção esclarece essa terminologia para facilitar seu aprendizado.

R segue uma filosofia fundamental: tudo que existe em R é um objeto. Isso significa que todos os elementos que você manipula — desde números simples até funções complexas — são tratados como objetos.

Esta abordagem difere de muitas outras linguagens de programação que fazem distinção clara entre “variáveis primitivas” (como números) e “objetos” (estruturas mais complexas).

Quando criamos algo em R usando um operador de atribuição (<-), estamos essencialmente:

Por exemplo, em idade <- 25, criamos um objeto do tipo numérico com valor 25 e o nomeamos como “idade”. Este nome funciona como uma etiqueta que nos permite acessar e manipular o objeto.

Por questões de clareza e para facilitar seu aprendizado:

Utilizarei o termo variável principalmente quando falarmos de valores simples que “variam”, como números, textos ou valores lógicos. Este termo é mais intuitivo para iniciantes e comum em estatística e análise de dados.

Utilizarei o termo objeto quando precisarmos enfatizar a natureza mais complexa de algumas estruturas em R, como data frames, listas, funções ou quando discutirmos conceitos mais avançados.

Em muitos contextos, usarei ambos os termos de forma intercambiável, refletindo a prática comum na comunidade R.

Esta flexibilidade terminológica espelha a documentação oficial da linguagem R e a literatura sobre a linguagem, preparando você para diferentes materiais que poderá encontrar em sua jornada de aprendizado.

Imagine uma biblioteca onde cada livro é um “objeto” de dados:

O conteúdo do livro representa os dados ou valores armazenados.

O título na lateral representa o nome da variável

As prateleiras e estantes representam a memória do computador

O catálogo da biblioteca equivale ao ambiente R, que mantém registro de onde cada objeto está armazenado

Quando você cria uma variável como receita <- 5000, é como se estivesse colocando um novo livro (com o conteúdo “5000”) na biblioteca e rotulando sua lateral como “receita” para poder encontrá-lo depois.

Este entendimento sobre variáveis e objetos em R estabelece uma base conceitual importante antes de mergulharmos nos tipos específicos de dados e em como manipulá-los para análises eficazes.

Em R, a atribuição de valores a variáveis é fundamental para armazenar e manipular dados. Por exemplo, podemos criar variáveis para armazenar informações financeiras, como receitas, custos e lucros, que são essenciais para análises em Administração.

[1] 350000Todas as instruções R com as quais criamos variáveis ou objetos têm o mesmo formato:

Lemos esse código como: “valor é atribuído a nome_objeto”

Em R, podemos atribuir informações às variáveis (ou objetos) utilizando os seguintes operadores de atribuição:

[1] 850000[1] 320000Em R, como em todas as linguagens, fazemos muitas atribuições de valores a variáveis, e não é agradável digitar o operador manualmente. Assim, o RStudio oferece um atalho de teclado simples para inserir o operador <-:

Atalho do RStudio: Alt + - (Windows/Linux) ou Option + - (Mac)

Observe que o RStudio automaticamente envolve <- com espaços, o que é uma boa prática de formatação de código.

Códigos sem espaços são difíceis de ler compare:

lucro<-receita-custos versus

lucro <- receita - custos

Nomes de variáveis devem começar com uma letra e podem conter letras, números, _ e .

É importante criar nomes de objetos simples e descritivos que representem claramente seu conteúdo. Em Administração, é comum trabalhar com dados financeiros, de desempenho ou de mercado, então use nomes que facilitem a compreensão do código.

Exemplos de boas práticas:

Estilos de nomenclatura:

margem_bruta, fluxo_caixa_operacionalMargemBruta, FluxoCaixaOperacionalEscolha um estilo e mantenha a consistência em todo o código.

Evite os seguintes erros comuns:

dados, resultado, xreceita_anual, lucro_liquidocalculo_da_margem_de_contribuicao_ajustadamargem_contribuicaomargem bruta <- 0.35 (causa erro)margem_bruta <- 0.351trimestre <- "Janeiro-Março" (inválido)trimestre1 <- "Janeiro-Março"mean <- 10 (sobrescreve a função mean())media <- 10Em R, existem algumas formas simples e eficazes de exibir informações sobre objetos ou variáveis. Esses métodos são ideais para visualizar valores, depurar código ou criar saídas personalizadas. Abaixo estão as principais formas:

1. Usando print()

A função print() é a maneira mais básica de exibir o conteúdo de um objeto:

[1] 850000.52. Imprimindo diretamente no console

Em R, você pode exibir o conteúdo de um objeto simplesmente digitando seu nome no console. Isso chama automaticamente a função print() implicitamente:

3. Usando a função cat()

A função cat() permite exibir informações de forma mais personalizada, combinando texto e valores. É útil para criar mensagens ou relatórios simples.

A receita mensal é: 850000.5Resumo:

Use print() para exibir valores de forma explícita.

Digite o nome do objeto diretamente no console para exibir seu valor de forma rápida.

Use cat() para criar saídas personalizadas, combinando texto e valores.

Em R, os dados são armazenados em diferentes tipos atômicos (básicos), cada um com características específicas. A Tabela 3 mostra os principais tipos.

| Tipo | Classe | Descrição |

|---|---|---|

double |

numeric |

um vetor contendo valores reais (números com casas decimais) |

integer |

numeric |

um vetor contendo valores inteiros (números sem casas decimais) |

character |

character |

um vetor contendo valores de texto (caracteres) |

logical |

logical |

um vetor contendo valores lógicos (TRUE/FALSE) |

A Tabela 2 exibe alguns tipos especiais que podem aparecer em análises de dados.

| Tipo | Descrição |

|---|---|

NA |

Not Available: representa dados faltantes |

NaN |

Not a Number: (ex: 0 / 0) |

Inf |

+ \infty ou - \infty: (ex: 1 / 0) |

Na prática da Ciência de Dados, estima-se que analistas e cientistas dedicam entre 60% a 80% do tempo de um projeto à importação, limpeza e preparação dos dados antes de iniciar análises mais sofisticadas. Compreender profundamente os tipos e classes de dados em R é fundamental por várias razões:

Evita erros sutis de processamento: Operações matemáticas em dados textuais ou cálculos com valores ausentes podem produzir resultados inesperados.

Otimiza o desempenho: Estruturas de dados apropriadas melhoram a eficiência computacional, especialmente em conjuntos grandes.

Facilita transformações: O conhecimento dos tipos permite conversões adequadas (como texto para número) sem perda de informação.

Melhora a interpretabilidade: Identificar corretamente dados faltantes (NA), indefinidos (NaN), ou infinitos (Inf) é crucial para conclusões válidas.

Aumenta a compatibilidade: Diferentes funções e pacotes em R exigem tipos específicos de dados como entrada.

O domínio dos tipos e classes de dados não é apenas uma questão técnica, mas um requisito fundamental para análises confiáveis em contextos administrativos e financeiros. Este conhecimento permite ao analista de dados concentrar-se mais nos insights e menos na correção de problemas estruturais nos dados.

double e integerEm R, existem dois tipos principais de dados numéricos:

double: Armazena números com casas decimais (ponto flutuante), ideal para valores monetários, índices financeiros, taxas percentuais e outras medidas que exigem precisão decimal.

integer: Armazena números inteiros sem casas decimais, útil para contagens, quantidades discretas e índices em séries temporais.

Na prática de Administração e Finanças, o tipo double é frequentemente utilizado para representar valores monetários, taxas de juros ou indicadores financeiros, enquanto integer é mais comum para representar quantidades como número de funcionários, produtos vendidos ou períodos de análise.

O sufixo L após um número (como em 50L) indica explicitamente que se trata de um valor inteiro. Na maioria das operações, R utiliza automaticamente o tipo mais apropriado, o que simplifica a programação para análises financeiras e administrativas.

[1] "double"[1] "integer"numeric

Apesar dos tipos double e integer representarem números decimais e inteiros de forma diferente, ambos pertencem à classe numeric, assim, na maioria das situações, você não precisa se preocupar com a possível diferença.

Diferença entre typeof e class

Em R, as funções typeof e class fornecem informações diferentes sobre um objeto:

typeof: Retorna o tipo interno do objeto, ou seja, como R armazena o objeto na memória. Por exemplo:class: Retorna a classe do objeto, que define como R trata o objeto em operações e funções. Por exemplo:Em resumo:

typeof para entender como R armazena o objeto internamente.class para entender como R trata o objeto em operações e funções.characterO tipo character é essencial para armazenar e manipular informações textuais. Este tipo de dado armazena sequências de caracteres (texto) e é indicado por aspas simples (') ou duplas (").

Em contextos de Administração, o tipo character é utilizado para armazenar:

A manipulação de dados textuais é particularmente importante em análises de mercado, pesquisas de satisfação, classificação de produtos e organização de relatórios gerenciais, onde a categorização textual precede análises quantitativas.

logicalO tipo logical representa valores booleanos (TRUE ou FALSE) e é fundamental para operações condicionais e filtragem de dados.

Em contextos práticos de gestão e finanças, o tipo logical é utilizado para:

Os valores TRUE e FALSE devem ser escritos em maiúsculas em R, e podem ser abreviados como T e F, respectivamente, embora a forma completa seja recomendada para maior clareza do código.

NAO tipo especial NA (Not Available) é comum em análises de dados reais, onde frequentemente nos deparamos com informações ausentes. Em contextos de Administração e Finanças, dados faltantes podem representar:

Identificar e tratar corretamente os valores NA é essencial para evitar conclusões tendenciosas. R oferece funções específicas como is.na() para detectar valores ausentes e métodos estatísticos para lidar com eles de forma apropriada.

[1] FALSE FALSE TRUE FALSE[1] 165000O tratamento adequado de dados falantes é uma habilidade fundamental em Ciência de Dados.

NaNO valor NaN (Not a Number) ocorre quando uma operação matemática produz um resultado indefinido. Em contextos de gestão e finanças, este tipo especial pode surgir em:

Enquanto NA representa dados ausentes, NaN indica especificamente um resultado numérico indefinido. Diferenciá-los é importante para diagnóstico de problemas em cálculos complexos, como em modelos de precificação de ativos ou simulações financeiras.

A função is.nan() permite identificar estes valores em conjuntos de dados:

infO valor especial Inf (e -Inf para infinito negativo) ocorre principalmente em divisões por zero e representa valores que excedem os limites computacionais. Em análises administrativas e financeiras, este tipo pode aparecer em:

Diferentemente de NA e NaN, valores Inf podem ser utilizados em operações aritméticas seguindo regras matemáticas de infinito:

[1] Inf[1] InfIdentificar valores infinitos é importante, por exemplo, em modelos financeiros, pois podem indicar problemas estruturais nas fórmulas utilizadas ou divisões por zero que comprometem a validade das análises.

Você pode estar se perguntando como converter um tipo ou classe de dados em outro(a) (por exemplo, transformar um texto em número ou vice-versa).

Embora R base ofereça funções como as.numeric(), as.character() e as.logical() para essas conversões, abordaremos este tópico mais adiante no tutorial, quando estudarmos a manipulação de dados com o pacote dplyr.

Especificamente, aprenderemos como usar as funções mutate() e transmute() para realizar conversões de tipos de maneira eficiente e legível em conjuntos de dados estruturados. Esta abordagem se alinha com as práticas modernas de ciência de dados e permite transformar múltiplas variáveis simultaneamente dentro de um fluxo de trabalho analítico coerente.

Por enquanto, foque em compreender as características e comportamentos dos diferentes tipos de dados apresentados nesta seção, pois este conhecimento fundamentará toda sua jornada na análise de dados com R.

Em R, os dados são organizados em diferentes estruturas, cada uma adequada a tipos específicos de operações e análises. As principais estruturas de dados são:

A compreensão dessas estruturas facilita uma escolha eficiente para diferentes contextos analíticos, sendo essencial para utilizar efetivamente os pacotes e recursos avançados do R.

A função básica para criar vetores é c(), que concatena valores.

Utilize colchetes [] para selecionar elementos. Lembre-se de que a indexação no R começa por 1.

R possui diversas funções que facilitam cálculos matemáticos e estatísticos diretamente aplicáveis a vetores. Algumas essenciais são:

[1] 25[1] 1 4 9 16 25[1] 945[1] 1 3 15 105 945[1] 0.000000 1.098612 1.609438 1.945910 2.197225[1] 2.718282 20.085537 148.413159 1096.633158 8103.083928[1] 5[1] 5[1] 3.162278[1] 10[1] 1[1] 9Essas funções são especialmente úteis em aplicações estatísticas e econométricas, como o cálculo de retornos médios, dispersão de dados financeiros ou identificação de extremos em séries temporais.

Operações matemáticas são aplicadas diretamente em vetores, permitindo grande eficiência:

Sempre verifique o tipo e comprimento dos vetores para evitar problemas na análise:

Além de numéricos, vetores podem conter caracteres (texto) ou valores lógicos:

typeof() e class() para checar e evitar coerções não desejadas.Matrizes são estruturas bidimensionais que organizam elementos homogêneos em linhas e colunas. Em análises estatísticas, econométricas e métodos numéricos, matrizes desempenham papel central, especialmente devido à eficiência computacional nas operações de álgebra linear.

[linha, coluna].Em R, matrizes são criadas com a função matrix(). Esta função recebe um vetor de dados e distribui-os em uma matriz especificando o número de linhas (nrow) ou colunas (ncol). O parâmetro byrow define se o preenchimento será feito por linhas (TRUE) ou por colunas (FALSE, padrão).

[,1] [,2] [,3]

[1,] 4 2 1

[2,] 3 5 2

[3,] 1 2 6 [,1] [,2] [,3]

[1,] 2 1 3

[2,] 1 4 2

[3,] 2 1 5 Intercepto X1 X2

[1,] 1 2 1.5

[2,] 1 3 2.0

[3,] 1 4 2.5

[4,] 1 5 3.0

[5,] 1 6 3.5As operações básicas entre matrizes ocorrem elemento a elemento ou por meio de multiplicação matricial:

[,1] [,2] [,3]

[1,] 6 3 4

[2,] 4 9 4

[3,] 3 3 11 [,1] [,2] [,3]

[1,] 2 1 -2

[2,] 2 1 0

[3,] -1 1 1 [,1] [,2] [,3]

[1,] 8 2 3

[2,] 3 20 4

[3,] 2 2 30 [,1] [,2] [,3]

[1,] 2.0 2.00 0.3333333

[2,] 3.0 1.25 1.0000000

[3,] 0.5 2.00 1.2000000 [,1] [,2] [,3]

[1,] 12 6 3

[2,] 9 15 6

[3,] 3 6 18 [,1] [,2] [,3]

[1,] 12 13 21

[2,] 15 25 29

[3,] 16 15 37 [,1] [,2] [,3]

[1,] 4 3 1

[2,] 2 5 2

[3,] 1 2 6O determinante indica se uma matriz quadrada é invertível (determinante diferente de zero). A inversa de uma matriz A é a matriz A^{-1} tal que A A^{-1} = I, onde I é a matriz identidade.

R permite criar matrizes especiais úteis em aplicações específicas:

[,1] [,2] [,3]

[1,] 1 0 0

[2,] 0 1 0

[3,] 0 0 1 [,1] [,2] [,3]

[1,] 2 0 0

[2,] 0 5 0

[3,] 0 0 3[1] 4 5 6 [,1] [,2] [,3]

[1,] 4 2 1

[2,] 0 5 2

[3,] 0 0 6 [,1] [,2] [,3]

[1,] 4 0 0

[2,] 3 5 0

[3,] 1 2 6Para uma matriz quadrada A, um autovalor \lambda e seu respectivo autovetor v satisfazem:

A v = \lambda v

Decomposições matriciais facilitam cálculos complexos e análises estruturais, expressando matrizes como produtos de outras com propriedades específicas.

Expressa uma matriz A como A = QR, onde Q é ortogonal e R é triangular superior.

Expressa qualquer matriz A como A = U D V', onde U e V são ortogonais e D é diagonal contendo valores singulares.

No modelo de regressão linear múltipla Y = X \beta + \varepsilon, a estimativa por Mínimos Quadrados Ordinários (MQO) é dada por:

\hat{\beta} = (X'X)^{-1} X'Y

Listas são as estruturas mais flexíveis do R, fundamentais em econometria para armazenar resultados de simulações, outputs de modelos estatísticos e organizar dados de diferentes tipos e dimensões. São especialmente úteis em simulações de Monte Carlo e no desenvolvimento de funções econométricas personalizadas.

# Lista para armazenar resultados de um modelo de regressão

set.seed(123)

n <- 100

X <- cbind(1, rnorm(n), rnorm(n)) # Matriz de regressores

beta_true <- c(2, 1.5, -0.8) # Parâmetros verdadeiros

epsilon <- rnorm(n, 0, 2) # Termo de erro

Y <- X %*% beta_true + epsilon # Variável dependente

# Estimação do modelo

XtX_inv <- solve(t(X) %*% X)

beta_hat <- XtX_inv %*% t(X) %*% Y

residuos <- Y - X %*% beta_hat

sigma2_hat <- sum(residuos^2) / (n - ncol(X))

# Armazenando resultados em uma lista

resultado_regressao <- list(

coeficientes = as.vector(beta_hat),

matriz_covariancia = sigma2_hat * XtX_inv,

residuos = as.vector(residuos),

R_quadrado = 1 - sum(residuos^2) / sum((Y - mean(Y))^2),

graus_liberdade = n - ncol(X),

observacoes = n,

dados = list(X = X, Y = Y)

)

# Visualizando a estrutura da lista

str(resultado_regressao)List of 7

$ coeficientes : num [1:3] 2.27 1.234 -0.752

$ matriz_covariancia: num [1:3, 1:3] 0.03697 -0.00376 0.00403 -0.00376 0.04399 ...

$ residuos : num [1:100] 4.012 2.281 -0.374 0.852 -1.019 ...

$ R_quadrado : num 0.346

$ graus_liberdade : num 97

$ observacoes : num 100

$ dados :List of 2

..$ X: num [1:100, 1:3] 1 1 1 1 1 1 1 1 1 1 ...

..$ Y: num [1:100, 1] 6.13 4.07 4.01 3.47 2.13 ...[1] 2.2701309 1.2336569 -0.7523774[1] 0.3462614[1] 0.3462614[1] 6.125232 4.074053 4.005126 3.470185 2.126547$coeficientes

[1] 2.2701309 1.2336569 -0.7523774

$R_quadrado

[1] 0.3462614# Função para simulação de Monte Carlo

simulacao_regressao <- function(n, beta_true, sigma, n_sim = 1000) {

# Lista para armazenar resultados de cada simulação

resultados <- list()

for(i in 1:n_sim) {

# Gerando dados

X <- cbind(1, rnorm(n), rnorm(n))

epsilon <- rnorm(n, 0, sigma)

Y <- X %*% beta_true + epsilon

# Estimando parâmetros

beta_hat <- solve(t(X) %*% X) %*% t(X) %*% Y

# Armazenando resultado da i-ésima simulação

resultados[[i]] <- list(

beta_hat = as.vector(beta_hat),

iteracao = i

)

}

return(resultados)

}

# Executando simulação (versão reduzida para demonstração)

set.seed(456)

sim_resultados <- simulacao_regressao(

n = 50,

beta_true = c(1, 2, -1),

sigma = 1,

n_sim = 100

)

# Analisando resultados da simulação

betas_simulados <- sapply(sim_resultados, function(x) x$beta_hat)

media_betas <- rowMeans(betas_simulados)

cat("Parâmetros verdadeiros:", c(1, 2, -1), "\n")Parâmetros verdadeiros: 1 2 -1 Média das estimativas: 1.013 2 -1.002 Número de simulações: 100 # Função para estimar e comparar diferentes modelos

comparar_modelos <- function(Y, X1, X2, X3) {

# Modelo 1: apenas X1

modelo1 <- lm(Y ~ X1)

# Modelo 2: X1 e X2

modelo2 <- lm(Y ~ X1 + X2)

# Modelo 3: X1, X2 e X3

modelo3 <- lm(Y ~ X1 + X2 + X3)

# Organizando resultados em lista

comparacao <- list(

modelo_1 = list(

coeficientes = coef(modelo1),

R2 = summary(modelo1)$r.squared,

AIC = AIC(modelo1),

n_parametros = length(coef(modelo1))

),

modelo_2 = list(

coeficientes = coef(modelo2),

R2 = summary(modelo2)$r.squared,

AIC = AIC(modelo2),

n_parametros = length(coef(modelo2))

),

modelo_3 = list(

coeficientes = coef(modelo3),

R2 = summary(modelo3)$r.squared,

AIC = AIC(modelo3),

n_parametros = length(coef(modelo3))

),

criterios_selecao = data.frame(

Modelo = c("Modelo 1", "Modelo 2", "Modelo 3"),

R2 = c(summary(modelo1)$r.squared,

summary(modelo2)$r.squared,

summary(modelo3)$r.squared),

AIC = c(AIC(modelo1), AIC(modelo2), AIC(modelo3))

)

)

return(comparacao)

}

# Gerando dados para demonstração

set.seed(789)

n <- 80

X1 <- rnorm(n)

X2 <- rnorm(n)

X3 <- rnorm(n)

Y <- 2 + 1.5*X1 + 0.8*X2 + rnorm(n, 0, 1)

# Executando comparação

resultados_comparacao <- comparar_modelos(Y, X1, X2, X3)

# Acessando resultados

print("Critérios de Seleção:")[1] "Critérios de Seleção:" Modelo R2 AIC

1 Modelo 1 0.5164472 280.1806

2 Modelo 2 0.7801518 219.1228

3 Modelo 3 0.7872469 218.4984

R² do melhor modelo: 0.7872469 # Função para realizar múltiplos testes diagnósticos

testes_diagnosticos <- function(modelo) {

# Teste de normalidade dos resíduos (Shapiro-Wilk)

teste_normalidade <- shapiro.test(residuals(modelo))

# Teste de heterocedasticidade (Breusch-Pagan simplificado)

residuos2 <- residuals(modelo)^2

valores_ajustados <- fitted(modelo)

teste_hetero <- summary(lm(residuos2 ~ valores_ajustados))

# Organizando resultados em lista estruturada

diagnosticos <- list(

normalidade = list(

estatistica = teste_normalidade$statistic,

p_valor = teste_normalidade$p.value,

interpretacao = ifelse(teste_normalidade$p.value > 0.05,

"Resíduos seguem distribuição normal",

"Evidência contra normalidade")

),

heterocedasticidade = list(

R2 = teste_hetero$r.squared,

F_estatistica = teste_hetero$fstatistic[1],

interpretacao = ifelse(teste_hetero$r.squared < 0.1,

"Não há evidência de heterocedasticidade",

"Possível heterocedasticidade")

),

resumo_modelo = list(

R2_ajustado = summary(modelo)$adj.r.squared,

erro_padrao = summary(modelo)$sigma,

observacoes = nobs(modelo)

)

)

return(diagnosticos)

}

# Aplicando função de testes

modelo_exemplo <- lm(Y ~ X1 + X2)

resultados_testes <- testes_diagnosticos(modelo_exemplo)

# Visualizando resultados

str(resultados_testes, max.level = 2)List of 3

$ normalidade :List of 3

..$ estatistica : Named num 0.973

.. ..- attr(*, "names")= chr "W"

..$ p_valor : num 0.0887

..$ interpretacao: chr "Resíduos seguem distribuição normal"

$ heterocedasticidade:List of 3

..$ R2 : num 0.00434

..$ F_estatistica: Named num 0.34

.. ..- attr(*, "names")= chr "value"

..$ interpretacao: chr "Não há evidência de heterocedasticidade"

$ resumo_modelo :List of 3

..$ R2_ajustado: num 0.774

..$ erro_padrao: num 0.923

..$ observacoes: int 80[1] "Resíduos seguem distribuição normal"[1] "Não há evidência de heterocedasticidade"As estruturas tabulares organizam informações em formato de tabela, com linhas representando observações e colunas representando variáveis. Data frames e tibbles constituem a base para a maioria das análises estatísticas e financeiras.

Estas estruturas permitem:

Diferentemente das matrizes (homogêneas), data frames e tibbles permitem colunas de tipos diferentes, sendo ideais para conjuntos de dados típicos em administração e finanças.

O data frame é a estrutura de dados mais utilizada em R para análises estatísticas. Conceptualmente similar a uma planilha, um data frame organiza dados em formato retangular onde cada linha representa uma observação e cada coluna representa uma variável.

Um data frame possui as seguintes características essenciais:

A função data.frame() permite criar estruturas tabulares combinando vetores de mesmo comprimento:

# Dados de desempenho empresarial

empresa <- c("TechCorp", "FinanceMax", "RetailPlus")

receita_milhoes <- c(125.8, 89.3, 156.7)

crescimento_percentual <- c(12.5, -3.2, 8.9)

meta_atingida <- c(TRUE, FALSE, TRUE)

# Criando o data frame

desempenho_empresas <- data.frame(

empresa = empresa,

receita_milhoes = receita_milhoes,

crescimento_percentual = crescimento_percentual,

meta_atingida = meta_atingida

)

# Exibindo o resultado

desempenho_empresas empresa receita_milhoes crescimento_percentual meta_atingida

1 TechCorp 125.8 12.5 TRUE

2 FinanceMax 89.3 -3.2 FALSE

3 RetailPlus 156.7 8.9 TRUEPara compreender a estrutura interna de um data frame, utilizamos funções específicas:

'data.frame': 3 obs. of 4 variables:

$ empresa : chr "TechCorp" "FinanceMax" "RetailPlus"

$ receita_milhoes : num 125.8 89.3 156.7

$ crescimento_percentual: num 12.5 -3.2 8.9

$ meta_atingida : logi TRUE FALSE TRUE[1] 3 4[1] "empresa" "receita_milhoes" "crescimento_percentual"

[4] "meta_atingida" [1] "1" "2" "3"R oferece múltiplas formas de acessar elementos em data frames:

[1] 125.8 89.3 156.7 empresa receita_milhoes

1 TechCorp 125.8

2 FinanceMax 89.3

3 RetailPlus 156.7[1] -3.2 empresa receita_milhoes crescimento_percentual meta_atingida

1 TechCorp 125.8 12.5 TRUE

3 RetailPlus 156.7 8.9 TRUEPara análises preliminares, a função summary() fornece estatísticas descritivas:

empresa receita_milhoes crescimento_percentual meta_atingida

Length:3 Min. : 89.3 Min. :-3.200 Mode :logical

Class :character 1st Qu.:107.5 1st Qu.: 2.850 FALSE:1

Mode :character Median :125.8 Median : 8.900 TRUE :2

Mean :123.9 Mean : 6.067

3rd Qu.:141.2 3rd Qu.:10.700

Max. :156.7 Max. :12.500 Tibbles são uma versão modernizada dos data frames, desenvolvida como parte do ecosistema tidyverse. Mantêm compatibilidade com data frames tradicionais, mas incorporam melhorias significativas para análise de dados contemporânea.

# A tibble: 3 × 4

empresa receita_milhoes crescimento_percentual meta_atingida

<chr> <dbl> <dbl> <lgl>

1 TechCorp 126. 12.5 TRUE

2 FinanceMax 89.3 -3.2 FALSE

3 RetailPlus 157. 8.9 TRUE A função tibble() oferece uma sintaxe mais moderna para criação:

# A tibble: 4 × 4

trimestre receita margem_bruta roi

<chr> <dbl> <dbl> <dbl>

1 Q1 2.8 0.32 0.358

2 Q2 3.1 0.35 0.434

3 Q3 3.5 0.38 0.532

4 Q4 4.2 0.41 0.689O tibble oferece funções específicas para inspeção detalhada:

Rows: 4

Columns: 4

$ trimestre <chr> "Q1", "Q2", "Q3", "Q4"

$ receita <dbl> 2.8, 3.1, 3.5, 4.2

$ margem_bruta <dbl> 0.32, 0.35, 0.38, 0.41

$ roi <dbl> 0.3584, 0.4340, 0.5320, 0.6888[1] "character"[1] "numeric"[1] "numeric"[1] "numeric"Para análises robustas, é fundamental identificar dados faltantes:

# A tibble: 4 × 4

empresa vendas custo lucro

<chr> <dbl> <dbl> <dbl>

1 Alpha 150 120 30

2 Beta NA 140 NA

3 Gamma 180 NA NA

4 Delta 165 135 30Coluna empresa : 0 valores ausentes

Coluna vendas : 1 valores ausentes

Coluna custo : 1 valores ausentes

Coluna lucro : 2 valores ausentes# A tibble: 2 × 4

empresa vendas custo lucro

<chr> <dbl> <dbl> <dbl>

1 Beta NA 140 NA

2 Gamma 180 NA NAPara demonstrar a aplicação prática dessas estruturas, utilizaremos dados reais de performance de carteiras do pacote PerformanceAnalytics:

library(PerformanceAnalytics)

library(tidyverse)

# Carregando dados de retornos de gestores e benchmarks

data(managers, package = "PerformanceAnalytics")

# Convertendo para tibble e preservando datas

retornos_gestores <- as_tibble(managers, rownames = "data")

# Exibindo estrutura dos dados

glimpse(retornos_gestores)Rows: 132

Columns: 11

$ data <chr> "1996-01-31", "1996-02-29", "1996-03-31", "1996-04-30", …

$ HAM1 <dbl> 0.0074, 0.0193, 0.0155, -0.0091, 0.0076, -0.0039, -0.023…

$ HAM2 <dbl> NA, NA, NA, NA, NA, NA, NA, -0.0001, 0.1002, 0.0338, 0.0…

$ HAM3 <dbl> 0.0349, 0.0351, 0.0258, 0.0449, 0.0353, -0.0303, -0.0337…

$ HAM4 <dbl> 0.0222, 0.0195, -0.0098, 0.0236, 0.0028, -0.0019, -0.044…

$ HAM5 <dbl> NA, NA, NA, NA, NA, NA, NA, NA, NA, NA, NA, NA, NA, NA, …

$ HAM6 <dbl> NA, NA, NA, NA, NA, NA, NA, NA, NA, NA, NA, NA, NA, NA, …

$ `EDHEC LS EQ` <dbl> NA, NA, NA, NA, NA, NA, NA, NA, NA, NA, NA, NA, 0.0281, …

$ `SP500 TR` <dbl> 0.0340, 0.0093, 0.0096, 0.0147, 0.0258, 0.0038, -0.0442,…

$ `US 10Y TR` <dbl> 0.00380, -0.03532, -0.01057, -0.01739, -0.00543, 0.01507…

$ `US 3m TR` <dbl> 0.00456, 0.00398, 0.00371, 0.00428, 0.00443, 0.00412, 0.…[1] "1996-01-31" "2006-12-31"Observações válidas por coluna:HAM1 : 132 observações

HAM2 : 125 observações

HAM3 : 132 observações

HAM4 : 132 observações

HAM5 : 77 observações

HAM6 : 64 observações

EDHEC LS EQ : 120 observações

SP500 TR : 132 observações

US 10Y TR : 132 observações

US 3m TR : 132 observações HAM1 HAM2 HAM3

Min. :-0.094400 Min. :-0.03710 Min. :-0.071800

1st Qu.:-0.000025 1st Qu.:-0.00980 1st Qu.:-0.005375

Median : 0.011150 Median : 0.00820 Median : 0.010200

Mean : 0.011123 Mean : 0.01414 Mean : 0.012447

3rd Qu.: 0.024850 3rd Qu.: 0.02520 3rd Qu.: 0.031375

Max. : 0.069200 Max. : 0.15560 Max. : 0.179600

NA's :7 Este conjunto de dados será utilizado nas próximas seções para demonstrar:

Nesta seção estabelecemos os fundamentos das principais estruturas de dados em R:

Critérios para Escolha da Estrutura:

Compreender quando e como utilizar cada estrutura é fundamental para desenvolver análises eficientes e código limpo em contextos administrativos e financeiros.

O tidyverse é um ecossistema coerente de pacotes R para ciência de dados que compartilham uma filosofia de design e gramática comuns.

Desenvolvido por Hadley Wickham e mantido pela Posit, o tidyverse facilita todo o fluxo de trabalho de análise de dados através de pacotes integrados.

readr/readxl: Importação eficiente de dados retangulares

tidyr: Estruturação de dados no formato “tidy” (pivot_longer, pivot_wider)

dplyr: Manipulação de dados com verbos intuitivos (filter, select, mutate)

ggplot2/gt: Visualização de dados baseada na gramática dos gráficos

O tidyverse implementa o princípio de “tidy data”, criando um fluxo de trabalho coeso através do operador pipe (%>% ou |>).

O grande poder do tidyverse está na integração entre seus pacotes. Exemplo: um fluxo completo que:

mutate)group_by, summarise)pivot_longer)ggplot2)%>% ou |>.A filosofia do tidyverse está alinhada com os princípios modernos de ciência de dados transparente, auditável e reproduzível.

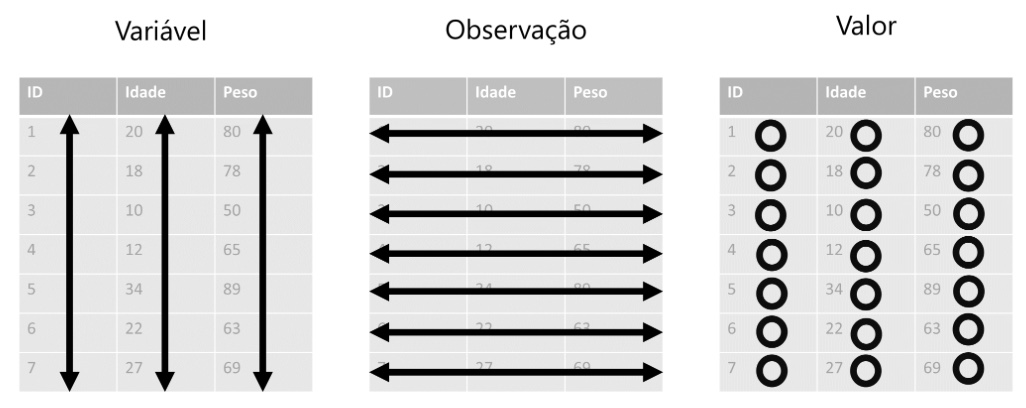

O conceito de Tidy Data (Dados Organizados) foi formalizado por Hadley Wickham.

Um arquivo de dados organizado possui a seguinte estrutura:

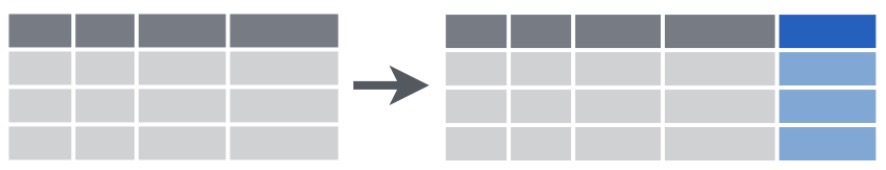

A Figura 1 ilustra o conceito de dados organizados visualmente.

Adequação para Ferramentas: Formato de armazenamento de dados adequado para análise em linguagens (R/Python) e softwares de análise de dados.

Consistência: Estrutura uniforme para todos os conjuntos de dados

Facilidade para operações comuns:

Colunas contendo valores: Nomes de colunas contendo valores de uma ou mais variáveis.

| Empresa | Ano | Valor |

|-----------|------|---------|

| Empresa A | 2020 | 350.000 |

| Empresa A | 2021 | 425.000 |

| Empresa A | 2022 | 510.000 |

| Empresa B | 2020 | 780.000 |

| Empresa B | 2021 | 815.000 |

| Empresa B | 2022 | 840.000 |

| Empresa C | 2020 | 540.000 |

| Empresa C | 2021 | 490.000 |

| Empresa C | 2022 | 620.000 |Características:

Múltiplas variáveis em uma coluna: Uma coluna contendo mais de uma variável

| Nome_Empresa (Ano) | Receita | Despesa |

|--------------------|---------------|---------------|

| Empresa A (2020) | R$ 350.000,00 | R$ 290.000,00 |

| Empresa A (2021) | R$ 425.000,00 | R$ 320.000,00 |

| Empresa B (2020) | R$ 780.000,00 | R$ 710.000,00 |

| Empresa B (2021) | R$ 815.000,00 | R$ 735.000,00 |Problemas:

| Empresa | Trimestre | Ano | Lucro_Liquido |

|-----------|-----------|------|---------------|

| TechSoft | T1 | 2023 | 25.3 |

| TechSoft | T2 | 2023 | 31.7 |

| TechSoft | T3 | 2023 | 28.4 |

| TechSoft | T4 | 2023 | 35.2 |

| VarejoMax | T1 | 2023 | 12.8 |

| VarejoMax | T2 | 2023 | 15.4 |

| VarejoMax | T3 | 2023 | 19.3 |

| VarejoMax | T4 | 2023 | 22.7 |

| FinGroup | T1 | 2023 | 41.6 |

| FinGroup | T2 | 2023 | 38.9 |

| FinGroup | T3 | 2023 | 45.2 |

| FinGroup | T4 | 2023 | 51.8 |Variáveis em linhas e colunas

| Empresa | Indicador | Valor |

|------------|---------------------|-------------|

| Empresa XYZ| ROE | 0.152 |

| Empresa XYZ| Liquidez Corrente | 1.8 |

| Empresa XYZ| Lucro Líquido | 2500000 |

| Empresa XYZ| Patrimônio Líquido | 16400000 |

| Empresa XYZ| Ativo Circulante | 3600000 |

| Empresa XYZ| Passivo Circulante | 2000000 |Por que a maioria das pessoas que trabalham na área de negócios não está familiarizada com os princípios da organização de dados para análise e utilizam planilhas eletrônicas para trabalhar com dados.

Planilhas de dados são frequentemente organizadas pensando em apresentar os dados ou para tornar a entrada de dados mais simples, não em um formato adequado para armazenamento e análise.

Isso significa que, para a maioria das análises reais, cientistas e analistas de dados dispendem muito tempo e esforço organizando e preparando dados elaborados por terceiros.

A primeira etapa é sempre descobrir quais são as observações e as variáveis associadas a cada observação.

Dados organizados viabilizam e facilitam a:

Reprodutibilidade: Formato padronizado que outros pesquisadores podem entender e utilizar

Visualizações avançadas: Estrutura ideal para a criação de diversos tipos de tabelas e gráficos.

Análise econométrica: Adequação imediata para estudos e modelos econométricos em (regressão linear, painel, logit, probit etc.)

Planilhas eletrônicas têm alto risco de erros: Em 13 auditorias de planilhas reais, uma média de 88% continham erros (Broman e Woo, 2018).

Problemas comuns incluem:

Conversão automática de formatos (ex: nomes de genes interpretados como datas)

Armazenamento de datas de forma diferente entre sistemas operacionais

Cálculos incorporados que podem corromper dados originais

A mistura de análise, visualização e armazenamento no mesmo arquivo aumenta o risco de comprometer os dados brutos e os resultados.

Mas dada a ubiquidade de planilhas nas organizações, caso precise usar planilhas para armazenar dados, siga as seguintes boas práticas:

Artigo de Broman e Woo (2018)

Crie planilhas organizadas (uma linha = uma observação, uma coluna = uma variável, uma célula = um valor)

Seja consistente e escolha bons nomes para as variáveis:

snake_case ou CamelCaseLucro Líquido (R$) 😱lucro_liquido ou LucroLiquido 😃Escreva datas conforme a Norma ISO 8601:

YYYY-MM-DD, exemplo: 2025-05-07Sem células vazias: use hífen (-) e no caso de usar R, use NA

Crie um dicionário dos dados

NUNCA faça cálculos na planilha dos dados originais/brutos

NUNCA use unidades de medida (R$), cor ou realce como um dado.

R$ 50.000,00 😱50000 😃10 % 😱O.1 😃Faça backups

Use validação dos dados para evitar erros

Salve os dados em arquivos de texto simples (.csv):

Na próxima seção, vamos aprender sobre como o pacote tidyr do tidyverse pode ser usado para tornar alguns tipos de dados desorganizados em dados organizados para análise.

O tidyr é um pacote do tidyverse para organizar dados desorganizados

Seu nome vem de “tidy” (organizado) + “r” (R)

Foi criado para facilitar a transformação de dados desorganizados em dados organizados (tidy data) para análise

É muito útil para a preparação de dados na fase 3 do CRISP-DM (Preparação dos Dados)

Permite que dados em formatos comuns de planilhas e relatórios sejam transformados em formatos adequados para análise e visualização

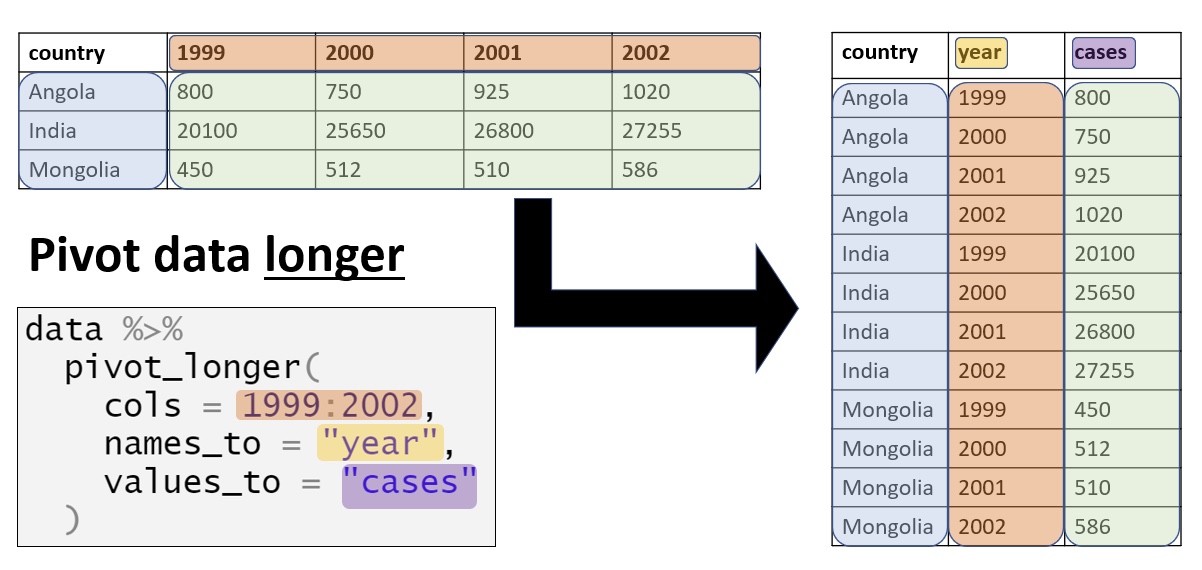

pivot_longer(): Converte dados do formato amplo (onde valores de uma ou mais variáveis são espalhadas por colunas) em um formato longo (onde cada variável está em uma única coluna).

Útil quando você precisa de de dados para análise ou visualização

Ex: Transformar colunas de trimestres (Q1, Q2, Q3, Q4) em uma única coluna “trimestre”

Iremos estudar somente a função pivot_longer(), porque o foco deste módulo é a preparação de dados para análise.

Mas há diversas outras funções úteis para a organização de dados:

Quando você tem planilhas financeiras com colunas para diferentes períodos (meses, trimestres, anos)

Quando você recebe planilhas Excel organizadas para visualização humana, mas não para análise de dados.

Quando precisa combinar dados de diferentes fontes que estão em formatos incompatíveis.

Quando precisa preparar dados para visualizações específicas com ggplot2 (gráficos de linhas, facetas, etc.)

Quando realiza análises temporais e precisa converter entre formatos de data/hora.

Aplicar a função pivot_longer() com seus parâmetros essenciais: cols, names_to e values_to

Organizar/Transformar dados complexos extraindo múltiplas informações de colunas

Integrar pivot_longer() em pipelines de análise com dplyr

Implementar soluções para casos reais de análise de dados administrativos

A função pivot_longer() converte dados do formato amplo (wide) para o formato longo (long)

É muito útil quando as colunas contêm valores em vez de variáveis

Geralmente, é o primeiro passo para transformar planilhas de negócios em dados organizados para análise (tidy data)

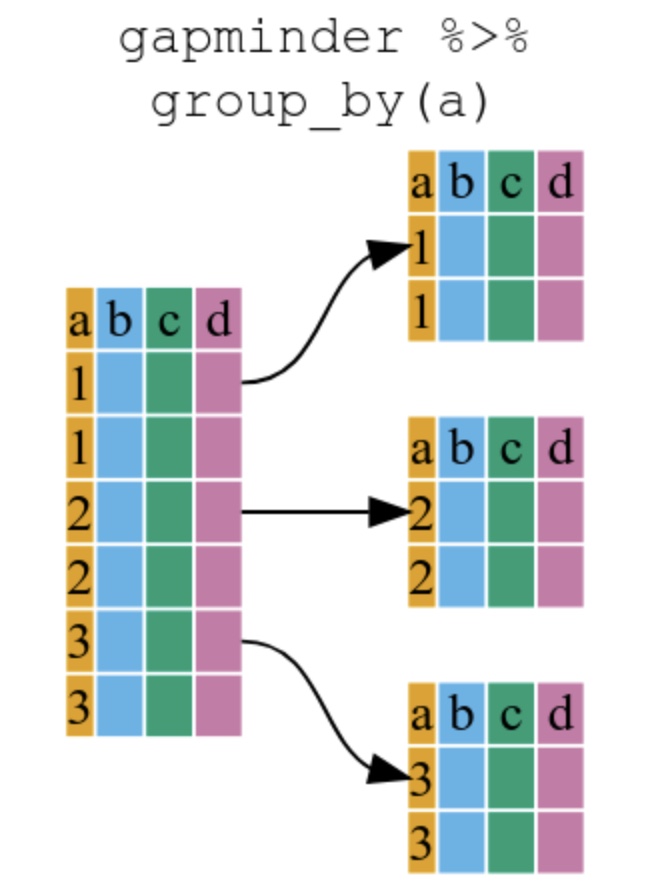

A Figura 2 ilustra o uso desta função

valores_de_uma_nova_coluna: as colunas que contêm valores de uma variável e serão transformadas.

nome_nova_coluna: nome da nova coluna/variável que conterá os nomes das colunas originais.

nome_outra_nova_coluna: nome da nova coluna/variável que conterá os valores originais.

| Característica | pivot_longer() |

|---|---|

| Transforma | Colunas → Linhas |

| Formato resultante | Longo (mais linhas) |

| Quando usar | Para análise e visualização |

| Exemplo típico | Transformar colunas de anos em uma variável “ano” |

A função tribble() (abreviação de “transposed tibble”) é uma forma elegante de criar pequenas tibbles/data frames para exemplos ou testes:

# Criando uma data frame com tribble() - "tibble transposta"

produtos <- tribble(

~codigo, ~produto, ~preco, # Nomes das colunas começam com ~

"A123", "Notebook", 3500, # Cada linha é um registro

"B456", "Smartphone", 1800, # Os valores são separados por vírgulas

"C789", "Monitor", 950 # A formatação facilita a leitura

)

# Visualizando a data frame criada

produtos# A tibble: 3 × 3

codigo produto preco

<chr> <chr> <dbl>

1 A123 Notebook 3500

2 B456 Smartphone 1800

3 C789 Monitor 950Vantagens da função tribble():

Layout Visual: Cada linha do código corresponde a uma linha da data frame, tornando o código mais legível

Especificação direta: Os nomes das colunas são definidos com ~ (til)

Flexibilidade de tipos: Cada coluna pode conter diferentes tipos de dados

Ideal para exemplos: Perfeita para criar pequenas data frames para demonstrações ou testes.

Esta função faz parte do pacote tibble, que é carregado automaticamente quando você carrega o tidyverse.

# A tibble: 3 × 5

produto T1 T2 T3 T4

<chr> <dbl> <dbl> <dbl> <dbl>

1 Produto A 50000 55000 60000 65000

2 Produto B 30000 32000 35000 37000

3 Produto C 20000 22000 25000 27000Este formato é para apresentação, não para armazenamento e análise.

# Transformando para o formato longo usando pivot_longer

receitas_longas <- receitas %>%

pivot_longer(

cols = c("T1", "T2", "T3", "T4"), # colunas que serão valores da nova coluna

names_to = "trimestre", # nome da nova coluna

values_to = "receita" # nome de outra nova coluna

)

# Visualizando o resultado (formato longo/long)

receitas_longas# A tibble: 12 × 3

produto trimestre receita

<chr> <chr> <dbl>

1 Produto A T1 50000

2 Produto A T2 55000

3 Produto A T3 60000

4 Produto A T4 65000

5 Produto B T1 30000

6 Produto B T2 32000

7 Produto B T3 35000

8 Produto B T4 37000

9 Produto C T1 20000

10 Produto C T2 22000

11 Produto C T3 25000

12 Produto C T4 27000Agora os dados estão organizados:

# Criando a data frame com múltiplas métricas por trimestre

desempenho <- tribble(

~empresa, ~receita_T1, ~receita_T2, ~despesa_T1, ~despesa_T2,

"Empresa A", 150000, 175000, 120000, 130000,

"Empresa B", 250000, 270000, 200000, 220000,

"Empresa C", 100000, 115000, 80000, 95000

)

# Visualizando a data frame original

desempenho# A tibble: 3 × 5

empresa receita_T1 receita_T2 despesa_T1 despesa_T2

<chr> <dbl> <dbl> <dbl> <dbl>

1 Empresa A 150000 175000 120000 130000

2 Empresa B 250000 270000 200000 220000

3 Empresa C 100000 115000 80000 95000Este formato é ainda mais desorganizado, pois mistura três variáveis (receita, despesa e trimestre) nos nomes das colunas.

# Transformando para o formato longo usando pivot_longer com nomes separados

desempenho_longo <- desempenho %>%

pivot_longer(

cols = -empresa, # todas as colunas exceto "empresa"

names_to = c("indicador", "trimestre"), # nomes das duas novas colunas

names_sep = "_", # separador nos nomes das colunas

values_to = "valor" # nome de nova coluna para receber os valores

)

# Visualizando o resultado

desempenho_longo# A tibble: 12 × 4

empresa indicador trimestre valor

<chr> <chr> <chr> <dbl>

1 Empresa A receita T1 150000

2 Empresa A receita T2 175000

3 Empresa A despesa T1 120000

4 Empresa A despesa T2 130000

5 Empresa B receita T1 250000

6 Empresa B receita T2 270000

7 Empresa B despesa T1 200000

8 Empresa B despesa T2 220000

9 Empresa C receita T1 100000

10 Empresa C receita T2 115000

11 Empresa C despesa T1 80000

12 Empresa C despesa T2 95000Observação importante:

Os nomes das colunas originais (receita_T1, receita_T2, etc.) são divididos pelo separador “_” em exatamente duas partes.

A primeira parte (“receita” ou “despesa”) vai para a coluna “indicador” e a segunda parte (“T1” ou “T2”) vai para a coluna “trimestre”.

Este é um padrão comum em dados financeiros: quando os nomes de colunas seguem um formato consistente com separadores, podemos extrair as informações contidas neles para criar novas variáveis.

# Exemplo mais gerenciável para slides

receita_trimestral <- tribble(

~empresa, ~`2022_T1_Receita`, ~`2022_T2_Receita`, ~`2023_T1_Receita`, ~`2023_T2_Receita`,

"ABC Ltda", 1200000, 1350000, 1500000, 1620000,

"XYZ S.A.", 2500000, 2700000, 2900000, 3100000

)

# Visualizando a data frame original

receita_trimestral# A tibble: 2 × 5

empresa `2022_T1_Receita` `2022_T2_Receita` `2023_T1_Receita`

<chr> <dbl> <dbl> <dbl>

1 ABC Ltda 1200000 1350000 1500000

2 XYZ S.A. 2500000 2700000 2900000

# ℹ 1 more variable: `2023_T2_Receita` <dbl># Transformando para o formato longo usando pivot_longer com três níveis

receita_trimestral_organizada <- receita_trimestral %>%

pivot_longer(

cols = -empresa, # todas as colunas exceto "empresa"

names_to = c("ano", "trimestre"), # nomes de duas novas colunas

names_sep = "_", # separador nos nomes das colunas

values_to = "receita" # nome de nova coluna para receber os valores da receita

)

# Visualizando o resultado

receita_trimestral_organizada# A tibble: 8 × 4

empresa ano trimestre receita

<chr> <chr> <chr> <dbl>

1 ABC Ltda 2022 T1 1200000

2 ABC Ltda 2022 T2 1350000

3 ABC Ltda 2023 T1 1500000

4 ABC Ltda 2023 T2 1620000

5 XYZ S.A. 2022 T1 2500000

6 XYZ S.A. 2022 T2 2700000

7 XYZ S.A. 2023 T1 2900000

8 XYZ S.A. 2023 T2 3100000Finalidade: Transformar dados do formato amplo (wide) para o formato longo (long), organizando-os conforme o princípio tidy data

Sintaxe básica:

cols: Quais colunas serão transformadas em pares nome-valornames_to: Nome da nova coluna que receberá os nomes das colunas originaisvalues_to: Nome da nova coluna que receberá os valores

4. Caso avançado:

Quando os nomes de colunas contêm múltiplas informações, use:

names_to = c("variavel1", "variavel2", ...)names_sep = "_" (ou outro separador presente nos nomes)

5. Benefícios:

Identifique as variáveis: Antes de transformar, identifique claramente quais são as observações e variáveis reais nos seus dados

Comece com subconjuntos: Para dados complexos, comece testando com um pequeno subconjunto de dados

Use nomes descritivos: Escolha bons nomes para as novas colunas criadas por pivot_longer()

Combine com dplyr: As transformações com tidyr geralmente são seguidas por operações com dplyr para análise

Verifique os resultados: Sempre confira se os dados transformados mantêm as mesmas informações dos dados originais

O que faz: O pacote tidyr transforma dados entre os formatos amplo (wide) e longo (long)

Principal função:

pivot_longer(): Converte de amplo (wide) para longo (long) (colunas para linhas)Quando usar:

pivot_longer() quando colunas contiverem valores em vez de variáveisImportância na análise de dados:

É essencial para a preparação de dados (fase 3 do CRISP-DM)

Permite transformar dados comuns de negócios em formatos adequados para análise

Facilita a aplicação de funções do dplyr e criação de visualizações

Lembre-se sempre:

O dplyr é um dos pacotes principais do tidyverse, criado por Hadley Wickham

Seu nome vem de “data plier” (alicate para dados) - uma ferramenta para manipular dados

Foi projetado seguindo a filosofia “tidy data” (dados organizados) - cada variável é uma coluna, cada observação é uma linha

É escrito em C++ para performance otimizada

Permite manipulação de dados de forma consistente, clara e encadeada

O pacote dplyr é parte do tidyverse

Enquanto os pacotes readr e readxl ajudam na importação de dados, o dplyr é especializado na manipulação de dados

O dplyr foi otimizado para manipular sobre dados organizados, longos ou tidy data

O dplyr trabalha com uma estrutura de dados de R que já conhecemos: data frames/tibbles

As funções do dplyr foram projetadas para serem usadas com o operador pipe (%>%), que já vimos brevemente no relatório Junglivet

Imagine o processo de análise de dados como uma linha de produção:

Os dados brutos são sua “matéria-prima”

Cada função do dplyr é uma “estação de trabalho” que realiza uma operação específica:

filter() seleciona apenas os materiais que atendem a certos critériosselect() separa apenas as partes que você precisamutate() transforma ou cria novos componentesgroup_by() + summarize() agrupam e calculam estatísticasarrange() organiza o resultado finalO operador pipe (%>%) é a “esteira” que move os dados de uma estação para outra

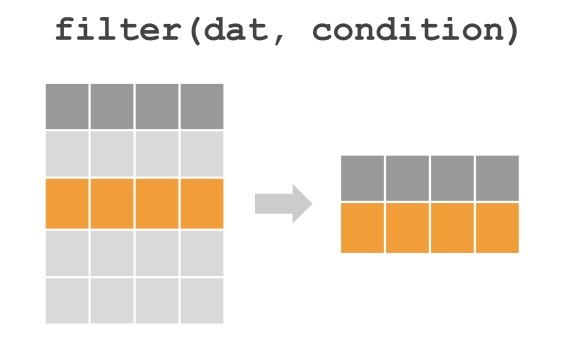

Muitas vezes precisamos filtrar somente certas linhas (observações ) de uma data frame.

Muitas vezes precisamos selecionar somente certas colunas (variáveis) de uma data frame.

Muitas vezes precisamos agrupar os dados por uma determinada(s) variável(s) categórica.

Muitas vezes precisamos calcular estatísticas descritivas para esses subconjuntos de dados (função summarize).

[1] 7136.11# A tibble: 1 × 1

`mean(gdpPercap)`

<dbl>

1 7136.[1] 7130.141Difícil de ler e entender

Propenso a erros

Difícil de modificar

Exemplo 2: Com dplyr e o operador pipe

# A tibble: 1 × 1

`mean(gdpPercap)`

<dbl>

1 7130.Base R: Funções aninhadas

Vantagens: Não requer pacotes adicionais, disponível em qualquer instalação do R

Desvantagens:

dplyr: Gramática da manipulação de dados

Vantagens:

Desvantagens:

O fluxo típico de uma análise de dados com tidyverse segue este padrão:

joins)filter)select)mutate)group_by)summarize)arrange)# Um pipeline de análise com dplyr

relatorio_expectativa <- gapminder %>%

# Filtra apenas os dados de 2007

filter(year == 2007) %>%

# Agrupa por continente

group_by(continent) %>%

# Calcula estatísticas resumidas

summarize(

expectativa_media = mean(lifeExp),

expectativa_minima = min(lifeExp),

expectativa_maxima = max(lifeExp),

num_paises = n()

) %>%

# Ordena do maior para o menor

arrange(desc(expectativa_media))

# Visualiza o resultado final

relatorio_expectativa# A tibble: 5 × 5

continent expectativa_media expectativa_minima expectativa_maxima num_paises

<fct> <dbl> <dbl> <dbl> <int>

1 Oceania 80.7 80.2 81.2 2

2 Europe 77.6 71.8 81.8 30

3 Americas 73.6 60.9 80.7 25

4 Asia 70.7 43.8 82.6 33

5 Africa 54.8 39.6 76.4 52Este exemplo demonstra como um conjunto de funções do dplyr pode ser combinado para transformar dados brutos organizados em um relatório informativo com apenas algumas linhas de código.

O pacote dplyr fornece uma série de funções muito úteis para manipular data frames de uma maneira que:

Vamos aprender 5 das funções mais usadas do pacote dplyr,

| Função | Descrição |

|---|---|

dplyr::filter() |

para filtrar linhas (observações) |

dplyr::select() |

para selecionar colunas (variáveis ) |

dplyr::mutate() |

para criar novas variáveis |

dplyr::group_by() |

para operações “por grupo” |

dplyr::summarize() |

para calcular estatísticas |

dplyr::arrange() |

para ordenar resultados |

Além disso, veremos como como usar o operador pipe (%>%) para combiná-las.

Indentação consistente:

Nomeie seu código:

dados_filtrados, relatorio_vendas_por_regiaoComente seu código:

Dividir análises complexas em etapas:

Consistência de estilo:

O pacote gapminder da linguagem R contém uma data frame também chamada gapminder.

A df gapminder fornece informações detalhadas sobre indicadores socioeconômicos reais de vários países ao longo do tempo.

Este conjunto de dados é muito utilizado no ensino da linguagem R e de métodos estatísticos.

Vamos utilizar a df gapminder para ilustrar as funções do pacote dplyr.

Para acessar os dados gapminder, basta instalar e carregar o pacote gapminder:

Para obter uma visão geral da estrutura da df gapminder, podemos usar a função glimpse do pacote dplyr:

Rows: 1,704

Columns: 6

$ country <fct> "Afghanistan", "Afghanistan", "Afghanistan", "Afghanistan", …

$ continent <fct> Asia, Asia, Asia, Asia, Asia, Asia, Asia, Asia, Asia, Asia, …

$ year <int> 1952, 1957, 1962, 1967, 1972, 1977, 1982, 1987, 1992, 1997, …

$ lifeExp <dbl> 28.801, 30.332, 31.997, 34.020, 36.088, 38.438, 39.854, 40.8…

$ pop <int> 8425333, 9240934, 10267083, 11537966, 13079460, 14880372, 12…

$ gdpPercap <dbl> 779.4453, 820.8530, 853.1007, 836.1971, 739.9811, 786.1134, …Podemos também inspecionar as primeiras 6 linhas da data frame com a função head:

# A tibble: 6 × 6

country continent year lifeExp pop gdpPercap

<fct> <fct> <int> <dbl> <int> <dbl>

1 Afghanistan Asia 1952 28.8 8425333 779.

2 Afghanistan Asia 1957 30.3 9240934 821.

3 Afghanistan Asia 1962 32.0 10267083 853.

4 Afghanistan Asia 1967 34.0 11537966 836.

5 Afghanistan Asia 1972 36.1 13079460 740.

6 Afghanistan Asia 1977 38.4 14880372 786.A data frame gapminder contida no pacote de mesmo nome, possui 1704 linhas (observações) e 6 colunas (variáveis).

| Variável | Classe/Tipo | Descrição |

|---|---|---|

country |

factor |

Nome do país (142 níveis/países) |

continent |

factor |

Continente ao qual o país pertence (5 níveis/continentes) |

year |

integer |

Ano da observação (1952 a 2007 em incrementos de 5 anos) |

lifeExp |

double |

Expectativa de vida ao nascer, em anos |

pop |

integer |

População total do país |

gdpPercap |

double |

PIB per capita em US$, ajustado pela inflação |

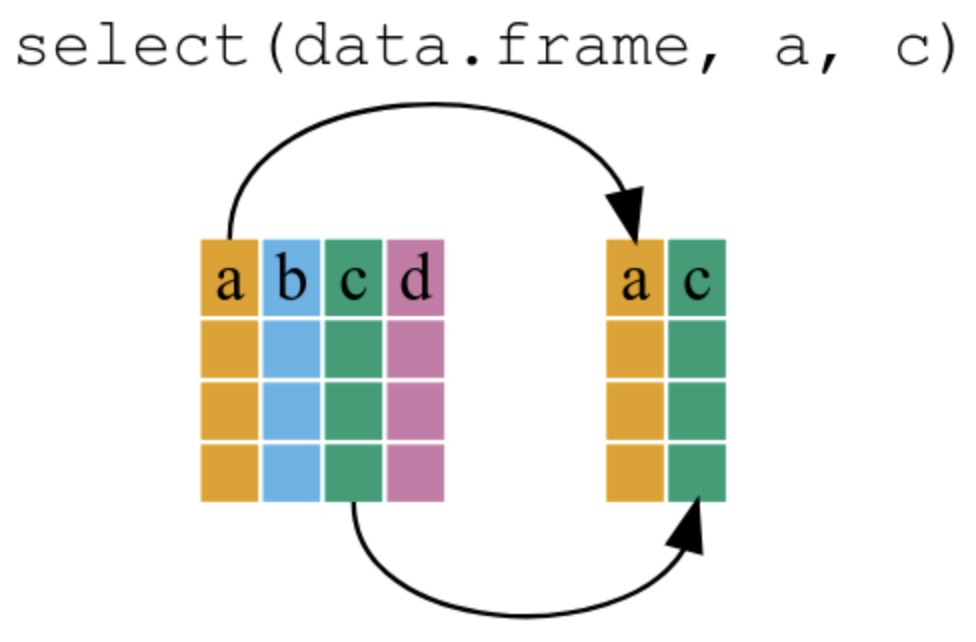

A função select() permite escolher quais variáveis (colunas) você quer manter ou remover de uma data frame

Enquanto select() trabalha com colunas (variáveis), filter() trabalha com linhas (observações),

É essencial para simplificar seus dados, focando apenas nas variáveis relevantes para sua análise

Imagine que você é um analista financeiro internacional e precisa preparar um relatório sobre PIB:

# A tibble: 6 × 3

country year gdpPercap

<fct> <int> <dbl>

1 Afghanistan 1952 779.

2 Afghanistan 1957 821.

3 Afghanistan 1962 853.

4 Afghanistan 1967 836.

5 Afghanistan 1972 740.

6 Afghanistan 1977 786.Interpretação: Este código seria equivalente a extrair apenas os dados financeiros relevantes (país, ano e PIB per capita) de uma grande base de dados para uma análise específica de desempenho econômico.

# Selecionar variáveis por inclusão

gapminder %>% select(country, year, gdpPercap)

# Selecionar variáveis por exclusão (com sinal de menos)

gapminder %>% select(-continent, -lifeExp)

# Selecionar variáveis em sequência

gapminder %>% select(country:pop)

# Selecionar variáveis que começam com determinado texto

gapminder %>% select(starts_with("c"))

# Selecionar variáveis que terminam com determinado texto

gapminder %>% select(ends_with("p"))

# Selecionar variáveis que contêm determinado texto

gapminder %>% select(contains("exp"))Estas técnicas são muito úteis quando você trabalha com:

| Erro | Errado | Correto |

|---|---|---|

| Nomes de variáveis com aspas | select(gapminder, "country") |

select(gapminder, country) |

| Tentar condições como em filter | select(gapminder, gdpPercap > 1000) |

Use filter() para isso, não select() |

| Não salvar o resultado | gapminder %>% select(country, year) |

dados_novos <- gapminder %>% select(country, year) |

| Remover variáveis necessárias | select(country) e depois tentar usar continent |

Verifique se manteve todas as variáveis necessárias |

Lembre-se: select() é para escolher colunas (variáveis) e filter() é para escolher linhas (observações)!

# A tibble: 1,704 × 5

country year lifeExp pop gdpPercap

<fct> <int> <dbl> <int> <dbl>

1 Afghanistan 1952 28.8 8425333 779.

2 Afghanistan 1957 30.3 9240934 821.

3 Afghanistan 1962 32.0 10267083 853.

4 Afghanistan 1967 34.0 11537966 836.

5 Afghanistan 1972 36.1 13079460 740.

6 Afghanistan 1977 38.4 14880372 786.

7 Afghanistan 1982 39.9 12881816 978.

8 Afghanistan 1987 40.8 13867957 852.

9 Afghanistan 1992 41.7 16317921 649.

10 Afghanistan 1997 41.8 22227415 635.

# ℹ 1,694 more rows|> ou %>%)|> ou %>%

Nos slides anteriores, usamos a sintáxe ‘normal’ da linguagem R.

Mas o ponto forte do dplyr está na combinação de várias funções usando o operador pipe %>%.

Vamos analisar a gramática do uso de funções do dplyr combinadas com o operador %>%.

Atalho para inserir o operador pipe: Ctrl + shift + M

O operador pipe pode ser lido como “então” ou “em seguida”

Fluxo da esquerda para a direita, similar à leitura natural

Transforma:

funcao(dados, arg1, arg2)

em

dados %>% funcao(arg1, arg2)

Uma linha de montagem onde cada função faz uma operação nos dados

# A tibble: 5 × 3

continent `mean(lifeExp)` `sum(pop)`

<fct> <dbl> <dbl>

1 Africa 54.8 929539692

2 Americas 73.6 898871184

3 Asia 70.7 3811953827

4 Europe 77.6 586098529

5 Oceania 80.7 24549947gapminder %>% # Pegue os dados gapminder, então...

filter(year == 2007) %>% # Filtre para apenas o ano 2007, então...

group_by(continent) %>% # Agrupe por continente, então...

summarize( # Calcule resumos:

exp_vida_media = mean(lifeExp), # expectativa de vida média

populacao_total = sum(pop) # população total

)# A tibble: 5 × 3

continent exp_vida_media populacao_total

<fct> <dbl> <dbl>

1 Africa 54.8 929539692

2 Americas 73.6 898871184

3 Asia 70.7 3811953827

4 Europe 77.6 586098529

5 Oceania 80.7 24549947Vamos entender o código:

Primeiro invocamos a df gapminder e a passamos, usando o operador pipe %>%, para a próxima etapa, que é a função select().

Neste caso, não especificamos qual df usamos na função select(), porque que ela obtém essa informação do pipe anterior.

Salvamos o resultado no objeto variaveis_selecionadas

Para que serve: Selecionar apenas as colunas (variáveis) que você deseja manter ou remover

Sintaxe básica:

select(país, ano, vendas)select(-observações, -notas)select(starts_with("venda"))select() trabalha com COLUNASfilter() trabalha com LINHASA função filter() permite filtrar subconjuntos de observações (linhas) que atendem determinadas condições ou critérios.

É uma das funções mais utilizadas na análise de dados para criar subconjuntos específicos dos dados

Pense nela como um “filtro” que deixa passar apenas as observações que atendem aos critérios que você definir

Imagine que você tem uma planilha de vendas e quer analisar apenas as vendas:

A função filter() permite fazer essa filtragem de forma rápida e precisa

| Operador | Exemplo em Linguagem Natural | Código em R |

|---|---|---|

| == | Apenas os países europeus | continent == “Europe” |

| != | Todos, exceto os países europeus | continent != “Europe” |

| > | Países com PIB per capita maior que 10.000 | gdpPercap > 10000 |

| < | Países com menos de 1 milhão de habitantes | pop < 1000000 |

| >= | Países a partir do ano 2000 | year >= 2000 |

| & | Países europeus a partir de 2000 | continent == “Europe” & year >= 2000 |

| |

Países da Europa ou da Ásia | continent == “Europe” | continent == “Asia” |

== para igualdade (lembre-se: dois sinais de igual, não apenas um)& para “E” (quero este critério E aquele também)| para “OU” (quero este critério OU aquele)Imagine que a data frame gapminder representa dados de filiais de uma empresa multinacional:

# A tibble: 6 × 6

country continent year lifeExp pop gdpPercap

<fct> <fct> <int> <dbl> <int> <dbl>

1 Argentina Americas 1952 62.5 17876956 5911.

2 Argentina Americas 1957 64.4 19610538 6857.

3 Argentina Americas 1962 65.1 21283783 7133.

4 Argentina Americas 1967 65.6 22934225 8053.

5 Argentina Americas 1972 67.1 24779799 9443.

6 Argentina Americas 1977 68.5 26983828 10079.Interpretação: Este filtro seria equivalente a selecionar apenas dados de filiais localizadas nas Américas para uma análise regional de desempenho.

| Pergunta de Negócio | Código com filter() |

|---|---|

| Quais países tiveram PIB per capita acima de $20.000 em 2007? | filter(year == 2007 & gdpPercap > 20000) |

| Quais países da Ásia tiveram expectativa de vida acima de 75 anos? | filter(continent == "Asia" & lifeExp > 75) |

| Quais países tiveram população superior a 100 milhões em 2007? | filter(year == 2007 & pop > 100000000) |

| Quais países não são da Europa nem da América? | filter(continent != "Europe" & continent != "Americas") |

Dica: Comece sempre pensando na pergunta de negócio, depois traduza para o código

Há duas maneiras principais de combinar condições:

Dica importante:

Com & (“E”) ambas as condições precisam ser TRUE para que a linha seja mantida

Com | (“OU”), apenas uma das condições precisa ser TRUE

Utilize operadores relacionais para:

# Países europeus em 2007, mostrando apenas país e expectativa de vida

europeus_lifeExp_2007 <- gapminder %>%

filter(continent == "Europe" & year == 2007) %>%

select(country, lifeExp)

# Ordenando o resultado por expectativa de vida (decrescente)

europeus_lifeExp_2007_ordenado <- gapminder %>%

filter(continent == "Europe" & year == 2007) %>%

select(country, lifeExp) %>%

arrange(desc(lifeExp))

head(europeus_lifeExp_2007_ordenado)# A tibble: 6 × 2

country lifeExp

<fct> <dbl>

1 Iceland 81.8

2 Switzerland 81.7

3 Spain 80.9

4 Sweden 80.9

5 France 80.7

6 Italy 80.5Ordem correta das operações:

Lembre-se: primeiro filter(), depois select()!

| Erro | Errado | Correto |

|---|---|---|

| Usar = em vez de == | filter(continent = "Europe") |

filter(continent == "Europe") |

| Esquecer as aspas em nomes | filter(continent == Europe) |

filter(continent == "Europe") |

| Não salvar o resultado | gapminder %>% filter(year == 2007) |

dados_2007 <- gapminder %>% filter(year == 2007) |

# Países europeus com expectativa de vida acima de 78 anos em 2007

resultado_final <- gapminder %>%

# Filtrar por continente, ano e expectativa de vida

filter(continent == "Europe" & year == 2007 & lifeExp > 78) %>%

# Selecionar variáveis de interesse

select(country, lifeExp, gdpPercap) %>%

# Ordenar por expectativa de vida (decrescente)

arrange(desc(lifeExp))

# Mostrar resultados

resultado_final# A tibble: 17 × 3

country lifeExp gdpPercap

<fct> <dbl> <dbl>

1 Iceland 81.8 36181.

2 Switzerland 81.7 37506.

3 Spain 80.9 28821.

4 Sweden 80.9 33860.

5 France 80.7 30470.

6 Italy 80.5 28570.

7 Norway 80.2 49357.

8 Austria 79.8 36126.

9 Netherlands 79.8 36798.

10 Greece 79.5 27538.

11 Belgium 79.4 33693.

12 United Kingdom 79.4 33203.

13 Germany 79.4 32170.

14 Finland 79.3 33207.

15 Ireland 78.9 40676.

16 Denmark 78.3 35278.

17 Portugal 78.1 20510.Observe o fluxo de análise:

Para que serve: Selecionar apenas as linhas (observações) que atendem a determinadas condições

Sintaxe básica:

Comparações mais usadas:

Múltiplas condições:

filter(condição1 & condição2)filter(condição1 | condição2)Lembre-se sempre de salvar o resultado:

A função mutate() permite criar novas variáveis ou modificar variáveis existentes

Enquanto filter() seleciona linhas e select() seleciona colunas, mutate() adiciona ou modifica colunas

É como ter uma “calculadora” que cria novas informações a partir dos dados existentes

Ideal para cálculos como: percentuais, totais, médias, categorias, etc.

O que cada parte significa:

Imagine que a data frame gapminder contém dados de vendas globais da sua empresa:

# Criando variáveis para análise de vendas

vendas_analise <- gapminder %>%

filter(year == 2007) %>% # Filtra dados somente de 2007

mutate(

# PIB total representa a receita total da região

receita_total = gdpPercap * pop,

# Receita em milhões (para facilitar a leitura)

receita_milhoes = receita_total / 1000000,

# Indicador de destaque (regiões com alta receita por pessoa)

destaque = gdpPercap > 20000

) %>%

# Vamos visualizar apenas algumas colunas e 5 linhas

select(country, receita_milhoes, gdpPercap, destaque) %>%

head(5)

vendas_analiseInterpretação administrativa: Este tipo de transformação é usado diariamente nas empresas para converter dados brutos em métricas de negócios úteis para tomada de decisão.

# Operações aritméticas básicas com mutate()

gapminder %>%

filter(country == "Brazil", year >= 2000) %>%

mutate(

# Adição: adiciona um valor fixo

pop_ajustada = pop + 1000000,

# Multiplicação: multiplica por um fator

gdp_reais = gdpPercap * 5.2, # Convertendo para reais

# Divisão: divide para mudar a escala

pop_milhoes = pop / 1000000 # População em milhões

) %>%

select(year, pop, pop_ajustada, pop_milhoes, gdpPercap, gdp_reais)Dica: As operações mais utilizadas em análises de negócios são multiplicação (para fatores, taxas, conversões) e divisão (para mudar escalas e calcular proporções).

A função ifelse() permite criar novas variáveis categóricas baseadas em condições:

Como funciona: ifelse(condição, valor_se_verdadeiro, valor_se_falso)

gapminder %>%

filter(year == 2007) %>%

mutate(

pib_total = gdpPercap * pop, # PIB total

pib_percentual_global = (pib_total/sum(pib_total))*100, # % do PIB global

performance = ifelse(gdpPercap > mean(gdpPercap),

"Acima da média",

"Abaixo da média")

) %>%

select(country, pib_total, pib_percentual_global, performance)Isso mostra como transformar dados brutos em informações gerenciais.

case_when() é como um “sistema de classificação” para criar categorias mais complexas:

# Exemplo de múltiplas categorias

paises_classificados <- gapminder %>%

filter(year == 2007) %>%

mutate(

classe_desenvolvimento = case_when(

gdpPercap < 2000 ~ "Baixo",

gdpPercap < 10000 ~ "Médio",

gdpPercap >= 10000 ~ "Alto"

)

) %>%

select(country, gdpPercap, classe_desenvolvimento) %>%

head(6)

paises_classificadosComo funciona:

condição ~ "valor a atribuir"| Função | Quando usar | Exemplo |

|---|---|---|

ifelse() |

Para divisões simples em duas categorias | ifelse(vendas > meta, "Meta atingida", "Meta não atingida") |

case_when() |

Para múltiplas categorias ou condições complexas | Classificar clientes em “Bronze”, “Prata”, “Ouro” e “Platina” baseado em diferentes critérios |

Analogia de negócios:

ifelse() é como uma decisão “sim/não” (aprovação de crédito simples)

case_when() é como um sistema de classificação de clientes com várias categorias

Usar o operador de atribuição errado

mutate(nova_var <- expressão) ❌mutate(nova_var = expressão) ✅Esquecer de salvar o resultado

dados %>% mutate(nova_var = x * 2) ❌ (resultado não salvo)dados_novos <- dados %>% mutate(nova_var = x * 2) ✅Tentar usar variáveis que acabou de criar sem manter os resultados

ERRADO:

CORRETO (Pipeline único):

O que faz: mutate() cria novas variáveis ou modifica existentes

Usos comuns no mundo dos negócios:

Como usar na prática:

Ferramentas complementares:

ifelse() para classificações simples (sim/não)case_when() para classificações múltiplasLembre-se de salvar o resultado em um novo objeto:

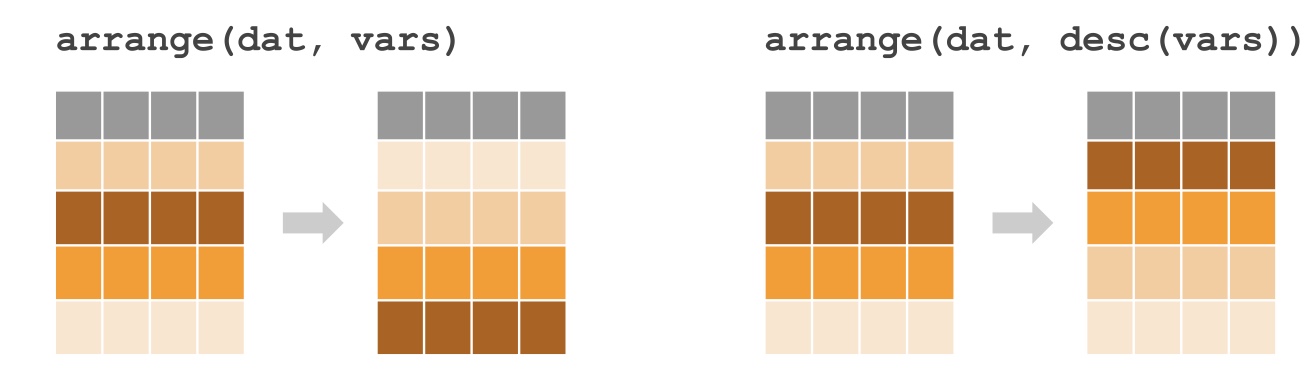

A função group_by() permite agrupar dados por uma ou mais variáveis categóricas

A função summarize() (ou summarise()) permite calcular estatísticas resumidas para cada grupo

Estas funções geralmente trabalham juntas como uma ferramenta poderosa para análise

É como criar “subtotais” ou “relatórios consolidados” por categorias (ex: vendas por região, despesas por departamento)

Imagine que você é um analista financeiro e precisa preparar um relatório executivo comparando regiões:

# Cria um relatório de PIB médio por continente

relatorio_continentes <- gapminder %>%

filter(year == 2007) %>% # Filtra para dados mais recentes

group_by(continent) %>% # Agrupa por continente

summarize(

PIB_medio = mean(gdpPercap), # Média do PIB per capita

Total_populacao = sum(pop), # População total

Paises_analisados = n(), # Número de países

PIB_minimo = min(gdpPercap), # PIB mínimo

PIB_maximo = max(gdpPercap) # PIB máximo

) %>%

arrange(desc(PIB_medio)) # Ordena do maior para o menor PIB médio

# Visualiza o resultado

relatorio_continentes# A tibble: 5 × 6

continent PIB_medio Total_populacao Paises_analisados PIB_minimo PIB_maximo

<fct> <dbl> <dbl> <int> <dbl> <dbl>

1 Oceania 29810. 24549947 2 25185. 34435.

2 Europe 25054. 586098529 30 5937. 49357.

3 Asia 12473. 3811953827 33 944 47307.

4 Americas 11003. 898871184 25 1202. 42952.

5 Africa 3089. 929539692 52 278. 13206.Interpretação Este tipo de relatório consolidado por região é crítico para análises comparativas entre mercados e para apresentações executivas. Mostra claramente as estatísticas-chave para cada grupo (continente), facilitando comparações e decisões estratégicas.

| Função | O que calcula | Exemplo em R | Uso em Negócios |

|---|---|---|---|

mean() |

Média | mean(vendas) |

Valor médio de vendas por região |

sum() |

Soma total | sum(receita) |

Receita total por categoria |

min() |

Valor mínimo | min(preco) |

Menor preço praticado |

max() |

Valor máximo | max(despesa) |

Maior despesa do período |

sd() |

Desvio padrão | sd(producao) |

Variabilidade da produção |

n() |

Contagem de linhas | n() |

Número de transações |

n_distinct() |